一.什么是codis集群

codis集群简介

-

Codis是一个分布式的Redis解决方案,对于上层的应用来说,连接Codis Proxy和连接原生的Redis Server没有明显的区别(不支持的命令列表),上层应用可以像使用单机的Redis一样使用,Codis底层会处理请求的转发,不停机的数据迁移等工作,所有后边的一切事情,对于前面客户端来说是透明的,可以简单的认为后边连接是一个内存无限大的Redis服务。

-

Codis是一套用go语言编写的,为了应对高并发环境下的redis集群软件,原理是对一个redis key操作前,先把这个key通过crc32算法,分配到不同redis的某一个slot上,实现并发读写功能.而且能通过zookeeper调用redis-sentinel来实现故障切换功能.现在最新版本是3.2.1,依托于redis3.2.9开发出来。

codis的优缺点

-

优点:实现高并发读写,数据一致性高。

-

缺点:性能有较大损耗,故障切换无法保证不丢key。无法进行读写分离。

codis的架构介绍

go

描述:codis依赖语言包

codis

描述:codis集群套件,里面含有redis相关程序和集群专用程序。主要功能程序解析:

codis-server:属于redis-server优化版,基于 redis-3.2.9 分支开发。增加了额外的数据结构,以支持slot 有关的操作以及数据迁移指令。

codis-proxy:客户端连接的 Redis 代理服务,实现了 Redis 协议。 除部分命令不支持以外(例如:keys*,flush ),表现的和原生的 Redis 没有区别(就像 Twemproxy)。

1. 对于同一个业务集群而言,可以同时部署多个 codis-proxy 实例; 2.不同 codis-proxy 之间由 codis-dashboard 保证状态同步。codis-dashboard:集群管理工具,支持 codis-proxy、codis-server

的添加、删除,以及据迁移等操作。在集群状态发生改变时,codis-dashboard 维护集群下所有codis-proxy的状态的一致性。对于同一个业务集群而言,同一个时刻 codis-dashboard 只能有 0个或者1个; 所有对集群的修改都必须通过 codis-dashboard 完成。Codis-fe:集群web管理界面。

多个集群实例共享可以共享同一个前端展示页面; 通过配置文件管理后端 codis-dashboard 列表,配置文件可自动更新。redis-sentinel:可以实现对Redis的监控、通知、自动故障转移。如果Master不能工作,则会自动启动故障转移进程,将其中的一个Slave提升为Master,其他的Slave重新设置新的Master服务。Sentinel的配置由codis-dashboard和zookeeper一起控制,不需要手工填写。

jdk

描述:zookeeper依赖语言包

zookeeper

描述:用于存放数据配置路由表。zookeeper简称zk。在生产环境中,zk部署越多,其可靠性越高。由于zk集群是以宕机个数过半才会让整个集群宕机,因此,奇数个zk更佳。

逻辑架构如下:

- 访问层:

访问方式可以是类似keepalived集群的vip方式,或者是通过java代码调用jodis控件再连接上zookeeper集群,然后查找到可用的proxy端,进而连接调用不同的codis-proxy地址来实现高可用的LVS和HA功能。

- 代理层:

中间层由codis-proxy和zookeeper处理数据走向和分配,通过crc32算法,把key平均分配在不同redis的某一个slot中。实现类似raid0的条带化,在旧版本的codis中,slot需要手工分配,在codis3.2之后,只要点一个按钮slot会自动分配,相当方便,但是也可以手动分配,需要另外调用codis-admin命令。

- 数据层:

最后codis-proxy把数据存进真实的redis-server主服务器上,由于codis的作者黄东旭相当注重数据一致性,不允许有数据延时造成的数据不一致,所以架构从一开始就没考虑主从读写分离。从服务器仅仅是作为故障切换的冗余架构,由codis-dashboard监控各服务的状态,然后通过改写zookeeper数据和调用redis-sentinel实现故障切换功能。

二.codis集群的搭建部署

| 主机 | 服务 |

|---|---|

| server1 | codis-server |

| server2 | codis-server |

| server3 | zk,codis-dashboard,codis-proxy,codis-fe,codis-server |

实验过程如下所示:

如果之前做过redis的服务,将redis服务停掉,因为会占用6379端口

第一步:配置server3

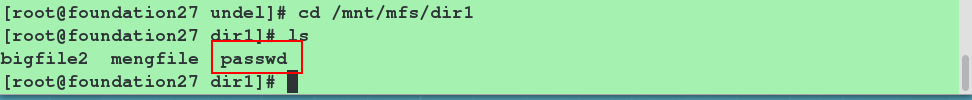

安装go(这里选用的版本为go1.9.1)——因为codis3.2要求至少是1.7或1.8以上版本。

[root@server3 ~]# tar zxf go1.9.1.linux-amd64.tar.gz -C /usr/local/ #-C:指定解压目录

[root@server3 ~]# cd /usr/local #查看

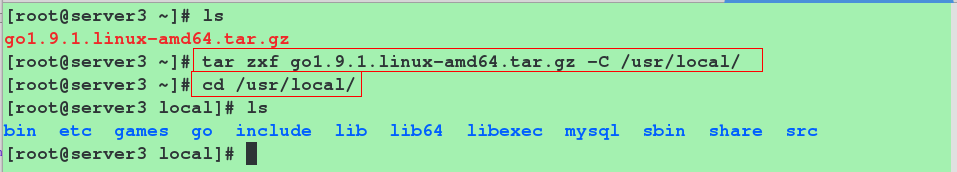

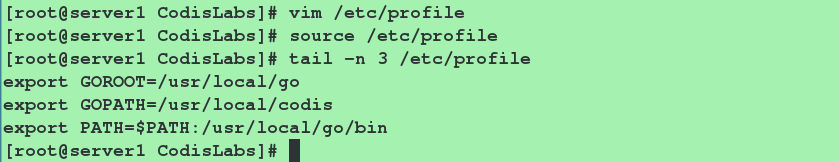

配置环境变量

[root@server3 ~]# vim /etc/profile #编辑环境变量的配置文件

78 export GOROOT=/usr/local/go

79 export GOPATH=/usr/local/codis

80 export PATH=$PATH:/usr/local/go/bin

[root@server3 ~]# source /etc/profile #重新加载环境变量,使得刚刚配置的环境变量生效

对codi进行源码编译(编译codis时依赖go,所以在安装codis先装好go)

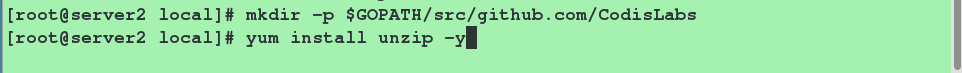

[root@server3 ~]# mkdir -p $GOPATH/src/github.com/CodisLabs #设置编译环境

[root@server3 ~]# yum install unzip -y #安装unzip软件,以支持unzip命令

[root@server3 ~]# unzip codis-release3.2.zip -d $GOPATH/src/github.com/CodisLabs

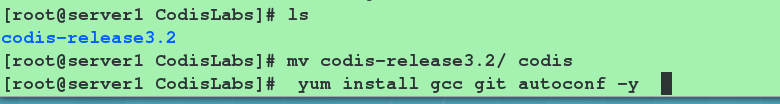

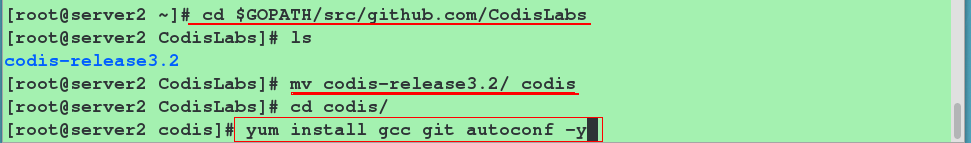

[root@server3 ~]# cd $GOPATH/src/github.com/CodisLabs

[root@server3 CodisLabs]# mv codis-release3.2/ codis #为了方便,将名字该为codis

[root@server3 CodisLabs]# cd codis/

[root@server3 codis]# yum install gcc git autoconf -y

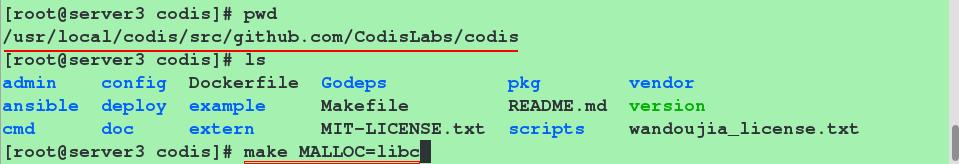

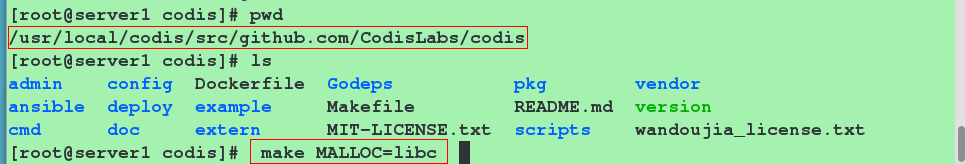

[root@server3 codis]# pwd

/usr/local/codis/src/github.com/CodisLabs/codis

[root@server3 codis]# make MALLOC=libc #进行编译安装

看到如下内容表示编译成功

补充:

codis源码编译完成之后:

-

组件的启动脚本在$GOPATH/src/github.com/CodisLabs/codis/admin目录下

-

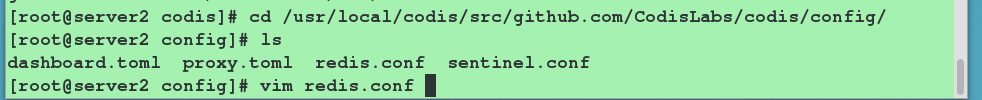

配置文件在$GOPATH/src/github.com/CodisLabs/codis/config目录下

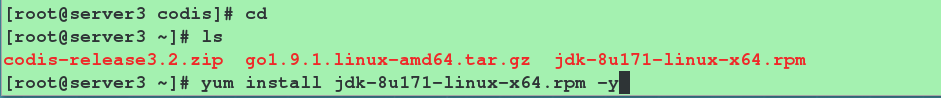

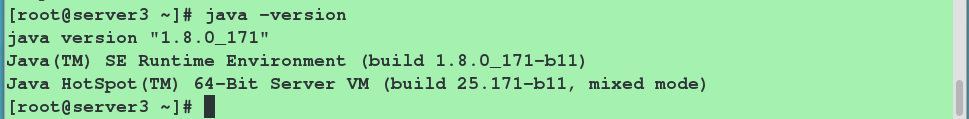

安装JDK (版本要求不严格)

[root@server3 ~]# yum install jdk-8u201-linux-x64.rpm -y

[root@server3 ~]# java -version 查看版本

安装zookeeper

[root@server3 ~]# tar zxf zookeeper-3.4.13.tar.gz -C /usr/local/ #-C:指定解压目录

[root@server3 ~]# cd /usr/local/

[root@server3 local]# mv zookeeper-3.4.13/ zookeeper

编辑环境变量

[root@server3 ~]# vim /etc/profile

78 export GOROOT=/usr/local/go

79 export GOPATH=/usr/local/codis

80 export ZOOKEEPER_HOME=/usr/local/zookeeper

81 export PATH=$PATH:/usr/local/go/bin:$ZOOKEEPER_HOME/bin

[root@server3 ~]# source /etc/profile #重新加载环境变量

修改zookeeper的配置文件

[root@server3 ~]# cd /usr/local/zookeeper/conf/

[root@server3 ~]# cp zoo_sample.cfg zoo.cfg

[root@server3 conf]# vim zoo.cfg

tickTime=2000 #一个周期(tick)的时长(单位:毫秒)

initLimit=10 #初始化同步阶段最多耗费tick个数

syncLimit=5 #等待应答的最大间隔tick个数

dataDir=/data/zookeeper/data #该目录需要手动建立。

clientPort=2181 #客户端连接server的端口,即对外服务端口,一般设置为 2181

maxClientCnxns=60 #最大连接数设置(单ip限制). 注:默认60,设成0即无限制

autopurge.purgeInterval=24 #ZK提供了自动清理事务日志和快照文件的功能,这个参数指定了清理频率,单位是小时

autopurge.snapRetainCount=500 这个参数和上面的参数搭配使用,这个参数指定了需要保留的文件数目。默认是保留3个

注意:因为我这里只部署单个codis-proxy节点的环境

如果是多个,需要在zookeeper的配置文件里面写入:

server.1=codis-1:2888:3888

server.2=codis-2:2888:3888

server.3=codis-3:2888:3888

说明:

server.A=B:C:D

- A 是一个数字,表示这个是第几号服务器;

- B 是这个服务器的 ip 地址;

- C 表示的是这个服务器与集群中的 Leader 服务器交换信息的端口;

- D 表示的是万一集群中的 Leader 服务器挂 了,需要一个端口来重新进行选举,选出一个新的Leader,而这个端口就是用来执行选举时服务器相互通信的 端口。

其中2888表示zookeeper程序监听端口,3888表示zookeeper选举通信端口。

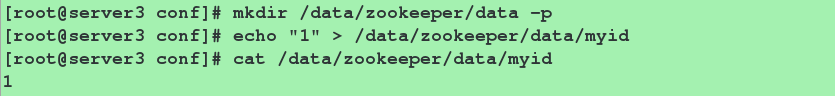

设置myid

设置myid在我们配置的dataDir指定的目录下面,创建一个myid文件,里面内容为一个数字(该数字的取值范围是1-255),用来标识当前主机,conf/zoo.cfg文件配置的server.X中的X是什么数字,则myid文件就输入这个数字,我只有一台zk,所以配置文件里可以不配置server.X,但还是要配置myid 的,echo一个数字1进去即可。如果有多台zk,则分别在zk服务器上echo对应的数字进对应的myid文件。

[root@server3 conf]# mkdir /data/zookeeper/data -p

[root@server3 conf]# echo "1" > /data/zookeeper/data/myid

启动zookeeper

[root@server3 ~]# zkServer.sh start #启动zookeeper

[root@server3 ~]# zkServer.sh status #查看zookeeper的状态

对codis进行配置,并启动codis的各个组件

注意:启动dashboard前,必须启动zookeeper服务,这是必须的。

编辑/usr/local/codis/config.ini文件并启动codis-dashboard组件

[root@server3 ~]# vim /usr/local/codis/config.ini

zk=localhost:2181 //zookeeper的地址

#如果是zookeeper集群,可以这么写:zk=hostname1:2181,hostname2:2181,hostname3:2181,hostname4:2181,hostname5:2181,

#如果是etcd,则写成:http://hostname1:port,http://hostname2:port,http://hostname3:port

product=meng //产品名称, 这个codis集群的名字, 可以认为是命名空间, 不同命名空间的codis没有交集

proxy_id=proxy_1 //proxy会读取, 用于标记proxy的名字, 针对多个proxy的情况, 可以使用不同的config.ini, 只需要更改 proxy_id 即可

net_timeout=5 //检测状态时间间隔

dashboard_addr=localhost:18087 //dashboard 服务的地址,CLI 的所有命令都依赖于 dashboard 的 RESTful API,所以必须启动

coordinator=zookeeper //如果用etcd,则将zookeeper替换为etcd

[root@server3 ~]# cd $GOPATH/src/github.com/CodisLabs/codis/admin

[root@server3 admin]# ./codis-dashboard-admin.sh start #启动codis-dashboard组件

启动codis-proxy组件和启动codis-fe组件

[root@server3 ~]# cd $GOPATH/src/github.com/CodisLabs/codis/admin

[root@server3 admin]# ./codis-proxy-admin.sh start

[root@server3 admin]# ./codis-fe-admin.sh start

启动codis-server组件并查看端口

[root@server3 admin]# ./codis-server-admin.sh start

[root@server3 admin] netstat -antlp

第二步:配置server1和server2(步骤完全相同)

- server1(基本步骤与server3相同)

注意:先编辑环境变量(这一步我当时在创建目录后面做,解压生成的目录路径不对,所以删除重新创建了,所以环境变量要在创建目录之前做)

编译完成界面:

对codis进行配置:

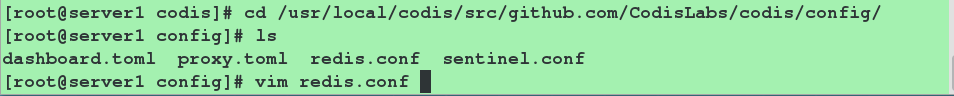

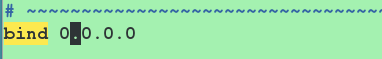

[root@server1 ~]# cd /usr/local/codis/src/github.com/CodisLabs/codis/config/

[root@server1 config]# vim redis.conf

bind 0.0.0.0

启动codis-server组件

[root@server1 ~]# cd /usr/local/codis/src/github.com/CodisLabs/codis/admin

[root@server1 admin]# ./codis-server-admin.sh start

- server2,配置过程同server1

第三步:测试

在浏览器访问172.25.27.3:9090,进入web管理界面

点击codis-demo并向下拉动界面

可以看到codis-proxy已经激活

可以新建组,也可以添加redis-server实例。

- 新建组

如下所示:

- 添加redis-server实例

点击Add Server,使实例127.0.0.1:6379添加成功

如下所示:

同理,可以添加172.25.27.1:6379和172.25.27.2:6379